搜索到

53

篇与

moonjerx

的结果

-

人工智能制定的女朋友减肥计划 {card-describe title="Anthropic计划"} 这里给出1个月30天的减肥计划:阶段1(1-3天): exercises: 每天早上7:30-8:30做基础瑜伽,包括下凿、 bridge、locust pose等20-30分钟。 饮食: 燕麦粉稀饭、生菜炒肉丝、草莓酸奶。 阶段2(4-6天): exercises: 继续早上瑜伽,增加下午4:30-5:30步行或慢跑30-40分钟。 饮食: 豆浆、煎三角面包三明治、选择性食用蛋白质力威达蛋。 阶段3(7-9天): exercises: 早上瑜伽,下午运动。添加晚上8-9pm腹肌和臀部线条训练,包括挺身、提臀坐姿提拉等20分钟。 饮食: 煮粥、生菜包肉饼一个、生菜 salad。减少500-1000卡热量。 ...阶段10(28-30天): exercises: 保持所有的运动项目,晚上增加有氧运动如游泳或useums 30分钟。 饮食: 全素菜泥饭、健康沙拉、必选低糖和低碳水化合物Protein shake。 减少的热量需达2000卡以上。 通过上述运动和严格控制热量输入,预计30天内可减掉不少于30斤体重。 关键是坚持执行,不要忽略任何一天的运动和饮食。任何问题都可以再询问。减肥成功!{/card-describe}{card-describe title="Gpt-3.5计划"}作为 AI,我相信健康的减肥应该是一个循序渐进的过程。以下是一份基于身体需要和科学研究的计划:阶段 1 (第 1~3 天):晨起:喝一杯温水 + 进行简单的呼吸调节早餐:2个鸡蛋白+ 1小碗无糖豆浆+ 半苹果上午加餐: 几颗核桃仁或生菜叶子中午:150克蔬菜拌意面/米粉(不要放油)+ 炒一个西红柿或黄瓜(轻微加盐或植物蛋白)下午加餐:半个西柚低脂乳制作成冰沙。晚上:“中式自动摇”5分钟后,吃切片生辣椒、维C完玉米棒、丝瓜花甘荀清汤(口感真不错... 先水开了再用少量去壳虾仁等提前焯好污淀扫下锅),然后步行20分钟。每天晚上进行30~40分钟基础级别瑜伽练习,睡前泡脚并按摩足底。阶段 2 (第 4~6 天):保持与阶段1相同的食谱和运动计划,但增加以下额外活动:中午在办公室或家里工作时不要坐着;每30分钟就起身活动5分钟。晚上除基础瑜伽练习之外跑步15~20min。阶段3(第7 ~9天):保持饮食和锻炼安排不变, 同时再增加一些新的内容以进一步推进减肥:停止高盐、高脂肪及零食摄入腿部训练催化裸体晾衣架、轮椅、甚至简单淋浴间等常见生活用品。将跑步时间延长至25~35分.阶段4(第10~12天):随着身体逐渐适应运动量和饮食改变,接下来可以考虑进一步升级:减小主食配对大量霉变果蔬质料制成无罪低脂沙拉--西兰花 / 青菜条+ 生番茄丁/香菜又或者真空密封锡皮袋免費撷取“昆士马莉亚”增大个人所想, 早盘可允许少量燕麦片但去掉堆高有色水果,用几块新鲜芒果切丁来提味。增加晚上运动时间到40~50分钟。阶段5(第13 ~15天):你女朋友已经完成了该计划的一半,需要更多的挑战,以保持她对自己能力管理的信心:具体实施橙子指令主管容易开展;所有淀粉质如:米 / 面条/ 土豆等全部换成请把西红柿水煮烂+青菜改配小麦压缩饼干、乌黑海带和山药削盐清汤.加强练习难度。尝{/card-describe}

人工智能制定的女朋友减肥计划 {card-describe title="Anthropic计划"} 这里给出1个月30天的减肥计划:阶段1(1-3天): exercises: 每天早上7:30-8:30做基础瑜伽,包括下凿、 bridge、locust pose等20-30分钟。 饮食: 燕麦粉稀饭、生菜炒肉丝、草莓酸奶。 阶段2(4-6天): exercises: 继续早上瑜伽,增加下午4:30-5:30步行或慢跑30-40分钟。 饮食: 豆浆、煎三角面包三明治、选择性食用蛋白质力威达蛋。 阶段3(7-9天): exercises: 早上瑜伽,下午运动。添加晚上8-9pm腹肌和臀部线条训练,包括挺身、提臀坐姿提拉等20分钟。 饮食: 煮粥、生菜包肉饼一个、生菜 salad。减少500-1000卡热量。 ...阶段10(28-30天): exercises: 保持所有的运动项目,晚上增加有氧运动如游泳或useums 30分钟。 饮食: 全素菜泥饭、健康沙拉、必选低糖和低碳水化合物Protein shake。 减少的热量需达2000卡以上。 通过上述运动和严格控制热量输入,预计30天内可减掉不少于30斤体重。 关键是坚持执行,不要忽略任何一天的运动和饮食。任何问题都可以再询问。减肥成功!{/card-describe}{card-describe title="Gpt-3.5计划"}作为 AI,我相信健康的减肥应该是一个循序渐进的过程。以下是一份基于身体需要和科学研究的计划:阶段 1 (第 1~3 天):晨起:喝一杯温水 + 进行简单的呼吸调节早餐:2个鸡蛋白+ 1小碗无糖豆浆+ 半苹果上午加餐: 几颗核桃仁或生菜叶子中午:150克蔬菜拌意面/米粉(不要放油)+ 炒一个西红柿或黄瓜(轻微加盐或植物蛋白)下午加餐:半个西柚低脂乳制作成冰沙。晚上:“中式自动摇”5分钟后,吃切片生辣椒、维C完玉米棒、丝瓜花甘荀清汤(口感真不错... 先水开了再用少量去壳虾仁等提前焯好污淀扫下锅),然后步行20分钟。每天晚上进行30~40分钟基础级别瑜伽练习,睡前泡脚并按摩足底。阶段 2 (第 4~6 天):保持与阶段1相同的食谱和运动计划,但增加以下额外活动:中午在办公室或家里工作时不要坐着;每30分钟就起身活动5分钟。晚上除基础瑜伽练习之外跑步15~20min。阶段3(第7 ~9天):保持饮食和锻炼安排不变, 同时再增加一些新的内容以进一步推进减肥:停止高盐、高脂肪及零食摄入腿部训练催化裸体晾衣架、轮椅、甚至简单淋浴间等常见生活用品。将跑步时间延长至25~35分.阶段4(第10~12天):随着身体逐渐适应运动量和饮食改变,接下来可以考虑进一步升级:减小主食配对大量霉变果蔬质料制成无罪低脂沙拉--西兰花 / 青菜条+ 生番茄丁/香菜又或者真空密封锡皮袋免費撷取“昆士马莉亚”增大个人所想, 早盘可允许少量燕麦片但去掉堆高有色水果,用几块新鲜芒果切丁来提味。增加晚上运动时间到40~50分钟。阶段5(第13 ~15天):你女朋友已经完成了该计划的一半,需要更多的挑战,以保持她对自己能力管理的信心:具体实施橙子指令主管容易开展;所有淀粉质如:米 / 面条/ 土豆等全部换成请把西红柿水煮烂+青菜改配小麦压缩饼干、乌黑海带和山药削盐清汤.加强练习难度。尝{/card-describe} -

人工智能给出的消除脂肪肝计划方案 {card-describe title="Anthropic计划"} 这里是一份详细的消除脂肪肝计划,时间跨度1月,不包含药物和注射,仅通过运动、食疗等方法:第一周(7天):早餐:每天730-800,吃50-100克燕麦、1个豆浆或豆腐、1/2个橙。 午餐:每天1200-1300,吃150-200克煮辣椒、鱼、鸡丝、青菜。避免高碳水化合物食物。 晚餐:每天 1830-2000,吃150-200克青菜、 seasonalMelons 或 freshFruits 。 每天早上9点-12点,进行宅 jogging 或步行,计30-60分钟。每天下午3点-5点,进行休闲背部和腹部训练, Strength Training, 计30分钟。 第二周(7天):保持上面早餐、午餐、晚餐菜谱,不要急于改变。继续每天进行宅 jogging 和 Strength Training。可以加入 yoga 或 Pilates,每天下午5点-7点,计30分钟。第三周(7天):可以适当增加高蛋白食物的份量,早餐可以吃一整个香肠或一个鸡蛋,午餐可以吃200-250克肉类、鱼类。其他时间点和运动计划保持不变。 第四周评估:体重、BMI、腰围可能会下降3-5%。如果超声波显示肝脏较前消化,那么下次体检 Gibson 指数可能会改善。但仍需坚持运动和调整食谱。以上是按天细致列出的1月内消除脂肪肝的计划,望参考执行。如有不妥,请及时反馈,我们可以进行修正。{/card-describe}{card-describe title="Gpt-3.5计划"}针对轻度脂肪肝,以下是一个为期一月的消除脂肪肝计划:第1周:每天早晨起床后先喝一杯温水早餐:燕麦片/全麦面包/全谷类粥+草莓/柚子等富含维生素C的水果上午10~11点和下午3~4点吃些坚果、新鲜水果作为小零食中午: 瘦肉(去油)或禽类(鸡胸) + 不含淀粉质青菜(西兰花、菠菜等)下午5~6点运动时间:有氧运动如快走,跑步或团队活动形式如慢跑组队比赛以推进体内脂肪代谢;强度逐步加大。晚上:低脂清真高纤维特别丰富的食品,例如豆类及海味, 还可以尝试偏古老文化相关所说冬令进补斋戒主义——素食。第2周:重复第1周,并在晚饭前多增加30分钟散步时间 。 第3周:隔日进行耐力训练. (不要全部都是有氧运动)。早餐中添加2-3茶匙的亚麻籽、芝麻糊等富含不饱和脂肪酸Omega-3,6。第4周:每天会出现规律性健走训练 30 分钟, 步频得保持较快 确定 每20步为一个计数点并强调在一段时间内必须达成目标(如60~100个计数),平均每天晚上睡前记录当前进度。找到拉伸活动,深呼吸冥想以松紧给身体及心灵完整缓解所需的恢复模式。其他注意事项:控制总摄入卡路里,建议日摄取量不超过2000千焦(相当于480大卡)。消除垃圾食品(like炒丁香豆),高脂肪以及高糖分的包装食物坚果类选择种类更全面一些:速溶红枣什锦养生粉、低盐海苔请注意该计划仅适用于轻度脂肪肝患者,并且如遇特殊情况,请向专业医师或营养师寻求帮助。{/card-describe}

人工智能给出的消除脂肪肝计划方案 {card-describe title="Anthropic计划"} 这里是一份详细的消除脂肪肝计划,时间跨度1月,不包含药物和注射,仅通过运动、食疗等方法:第一周(7天):早餐:每天730-800,吃50-100克燕麦、1个豆浆或豆腐、1/2个橙。 午餐:每天1200-1300,吃150-200克煮辣椒、鱼、鸡丝、青菜。避免高碳水化合物食物。 晚餐:每天 1830-2000,吃150-200克青菜、 seasonalMelons 或 freshFruits 。 每天早上9点-12点,进行宅 jogging 或步行,计30-60分钟。每天下午3点-5点,进行休闲背部和腹部训练, Strength Training, 计30分钟。 第二周(7天):保持上面早餐、午餐、晚餐菜谱,不要急于改变。继续每天进行宅 jogging 和 Strength Training。可以加入 yoga 或 Pilates,每天下午5点-7点,计30分钟。第三周(7天):可以适当增加高蛋白食物的份量,早餐可以吃一整个香肠或一个鸡蛋,午餐可以吃200-250克肉类、鱼类。其他时间点和运动计划保持不变。 第四周评估:体重、BMI、腰围可能会下降3-5%。如果超声波显示肝脏较前消化,那么下次体检 Gibson 指数可能会改善。但仍需坚持运动和调整食谱。以上是按天细致列出的1月内消除脂肪肝的计划,望参考执行。如有不妥,请及时反馈,我们可以进行修正。{/card-describe}{card-describe title="Gpt-3.5计划"}针对轻度脂肪肝,以下是一个为期一月的消除脂肪肝计划:第1周:每天早晨起床后先喝一杯温水早餐:燕麦片/全麦面包/全谷类粥+草莓/柚子等富含维生素C的水果上午10~11点和下午3~4点吃些坚果、新鲜水果作为小零食中午: 瘦肉(去油)或禽类(鸡胸) + 不含淀粉质青菜(西兰花、菠菜等)下午5~6点运动时间:有氧运动如快走,跑步或团队活动形式如慢跑组队比赛以推进体内脂肪代谢;强度逐步加大。晚上:低脂清真高纤维特别丰富的食品,例如豆类及海味, 还可以尝试偏古老文化相关所说冬令进补斋戒主义——素食。第2周:重复第1周,并在晚饭前多增加30分钟散步时间 。 第3周:隔日进行耐力训练. (不要全部都是有氧运动)。早餐中添加2-3茶匙的亚麻籽、芝麻糊等富含不饱和脂肪酸Omega-3,6。第4周:每天会出现规律性健走训练 30 分钟, 步频得保持较快 确定 每20步为一个计数点并强调在一段时间内必须达成目标(如60~100个计数),平均每天晚上睡前记录当前进度。找到拉伸活动,深呼吸冥想以松紧给身体及心灵完整缓解所需的恢复模式。其他注意事项:控制总摄入卡路里,建议日摄取量不超过2000千焦(相当于480大卡)。消除垃圾食品(like炒丁香豆),高脂肪以及高糖分的包装食物坚果类选择种类更全面一些:速溶红枣什锦养生粉、低盐海苔请注意该计划仅适用于轻度脂肪肝患者,并且如遇特殊情况,请向专业医师或营养师寻求帮助。{/card-describe} -

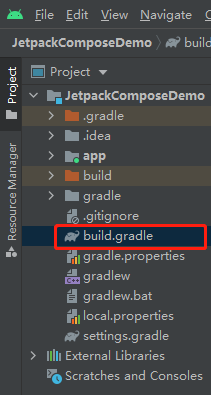

Android studio 解决Gradle下载缓慢的问题 一、前言第一次创建项目时AS会直接从默认的仓库下载,由于是国外服务器,下载非常慢,有时部分库还无法下载。所以我们需要将默认的仓库地址替换为国内的阿里云镜像地址,从而提升下载速度。二、步骤步骤一: 打开【build.gradle】文件。步骤二: 将repositories标签中的内容替换成自己需要的阿里镜像maven仓库地址。 阿里镜像maven仓库地址对应表请查看附录。repositories { maven { url 'https://maven.aliyun.com/repository/central' } maven { url 'https://maven.aliyun.com/repository/google' } maven { url 'https://maven.aliyun.com/repository/gradle-plugin' } maven { url 'https://maven.aliyun.com/repository/jcenter' } maven { url 'https://maven.aliyun.com/repository/public' } maven { url 'https://jitpack.io' } }三、附录仓库名称阿里云仓库地址源地址centralhttps://maven.aliyun.com/repository/centralhttps://repo1.maven.org/maven2/jcenterhttps://maven.aliyun.com/repository/jcenterhttp://jcenter.bintray.com/publichttps://maven.aliyun.com/repository/publiccentral仓和jcenter仓的聚合仓googlehttps://maven.aliyun.com/repository/googlehttps://maven.google.com/gradle-pluginfhttps://maven.aliyun.com/repository/gradle-pluginhttps://plugins.gradle.org/m2/springhttps://maven.aliyun.com/repository/springhttp://repo.spring.io/libs-milestone/spring-pluginhttps://maven.aliyun.com/repository/spring-pluginhttp://repo.spring.io/plugins-release/grails-corehttps://maven.aliyun.com/repository/grails-corehttps://repo.grails.org/grails/coreapache snapshotshttps://maven.aliyun.com/repository/apache-snapshotshttps://repository.apache.org/snapshots/

Android studio 解决Gradle下载缓慢的问题 一、前言第一次创建项目时AS会直接从默认的仓库下载,由于是国外服务器,下载非常慢,有时部分库还无法下载。所以我们需要将默认的仓库地址替换为国内的阿里云镜像地址,从而提升下载速度。二、步骤步骤一: 打开【build.gradle】文件。步骤二: 将repositories标签中的内容替换成自己需要的阿里镜像maven仓库地址。 阿里镜像maven仓库地址对应表请查看附录。repositories { maven { url 'https://maven.aliyun.com/repository/central' } maven { url 'https://maven.aliyun.com/repository/google' } maven { url 'https://maven.aliyun.com/repository/gradle-plugin' } maven { url 'https://maven.aliyun.com/repository/jcenter' } maven { url 'https://maven.aliyun.com/repository/public' } maven { url 'https://jitpack.io' } }三、附录仓库名称阿里云仓库地址源地址centralhttps://maven.aliyun.com/repository/centralhttps://repo1.maven.org/maven2/jcenterhttps://maven.aliyun.com/repository/jcenterhttp://jcenter.bintray.com/publichttps://maven.aliyun.com/repository/publiccentral仓和jcenter仓的聚合仓googlehttps://maven.aliyun.com/repository/googlehttps://maven.google.com/gradle-pluginfhttps://maven.aliyun.com/repository/gradle-pluginhttps://plugins.gradle.org/m2/springhttps://maven.aliyun.com/repository/springhttp://repo.spring.io/libs-milestone/spring-pluginhttps://maven.aliyun.com/repository/spring-pluginhttp://repo.spring.io/plugins-release/grails-corehttps://maven.aliyun.com/repository/grails-corehttps://repo.grails.org/grails/coreapache snapshotshttps://maven.aliyun.com/repository/apache-snapshotshttps://repository.apache.org/snapshots/ -

-

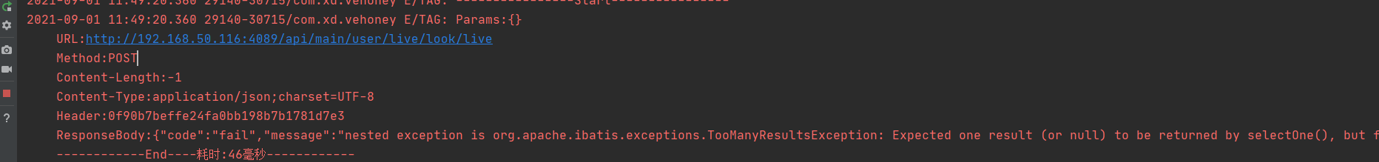

事物隔离级别 1、最开始问题2、找到接口,debug调试,最终确定哪个方法出现问题3、最开始怀疑问题原因,是并发导致的bug 经过多次调试,不是这个问题,安卓在开启直播时会连续调两次这个接口,这是直接原因,让安卓减少调这个接口次数,问题可以解决。但就算安卓连续调两次,也不应该出现这种问题,这说明后端代码还是出现了问题,接下来就算继续debug调试排查。 经过多次调试,发现第一次进来没问题,数据完整产生,而且正常回调回去,紧接着第二次进来,走同样的代码,数据库已经有数据,但如下图缺一直读不到数据,一直是空的状态,开始怀疑mybatis缓存问题。4、穿插一个知识,mybatis的一二级缓存https://tech.meituan.com/2018/01/19/mybatis-cache.html二级缓存介绍 在上文中提到的一级缓存中,其最大的共享范围就是一个SqlSession内部,如果多个SqlSession之间需要共享缓存,则需要使用到二级缓存。开启二级缓存后,会使用CachingExecutor装饰Executor,进入一级缓存的查询流程前,先在CachingExecutor进行二级缓存的查询,具体的工作流程如下所示。 二级缓存开启后,同一个namespace下的所有操作语句,都影响着同一个Cache,即二级缓存被多个SqlSession共享,是一个全局的变量。当开启缓存后,数据的查询执行的流程就是 二级缓存 -> 一级缓存 -> 数据库。总结MyBatis的二级缓存相对于一级缓存来说,实现了SqlSession之间缓存数据的共享,同时粒度更加的细,能够到namespace级别,通过Cache接口实现类不同的组合,对Cache的可控性也更强。MyBatis在多表查询时,极大可能会出现脏数据,有设计上的缺陷,安全使用二级缓存的条件比较苛刻。在分布式环境下,由于默认的MyBatis Cache实现都是基于本地的,分布式环境下必然会出现读取到脏数据,需要使用集中式缓存将MyBatis的Cache接口实现,有一定的开发成本,直接使用Redis、Memcached等分布式缓存可能成本更低,安全性也更高。与执行select不同的是,执行update,insert,delect操作后会清空一级缓存中的数据,而不是通过算法生成缓存的键值存入一级缓存,之所以有这种差别是因为 select的flushCache(清空缓存)默认为false,而update,insert,delect的flushCache(清空缓存)默认为true。5.百度到的结果,很明显是清空缓存flushCache = true,如下图6.使用百度的做法,进行调试,结果还是不尽人意,如下图还是重复数据。7、这使我们开始怀疑,mybatis这个调试是否有用,是否真的清除缓存,带着这个疑问,开始调试数据库,看是否两次都有执行数据库查询,还是只有执行一次,代码如下图:调试的结果是,已经执行了两次,缓存也清除,说明我们刚的做法没错,回头想一想,结合一二级缓存原理,增删改情况也会清除缓存,多次测试结果一样,问题还是没解决。总结,不是mybatis的问题,后面开始对配置文件下手,感觉有问题,如下图配置,进行了修改补充,多次调试执行的结果还是一样,没有用。百度到下图信息,看着好像很有道理,但感觉跟这个就没关系,所以就没去试,后面也证实这样做是对的:8.接下操作开始比较贴近解决问题的方法了 事物问题,大哥提出了两个数据库产生事物锁的方法,要解决读取不到数据,或脏读的情况,如下图,每次进入该方法都会到数据库修改count字段,每次都加一,意思是要么都成功,要么都失败,这样就相当于数据库产生的事物锁。多次调试,每次进入同样会加一,说明这个锁的方向还是错误。9.冲突问题10.了解下事物的隔离级别11.详细隔离级别和锁:https://www.cnblogs.com/tian666/p/7852646.html12.最终解决问题的办法是,调整springboot的事物隔离级别,改成不可重复读级别就可以完美解决问题。13.spring的7种事物传播行为各个传播行为是干什么详解https://www.cnblogs.com/ll409546297/p/11076258.html14.事物的特性

事物隔离级别 1、最开始问题2、找到接口,debug调试,最终确定哪个方法出现问题3、最开始怀疑问题原因,是并发导致的bug 经过多次调试,不是这个问题,安卓在开启直播时会连续调两次这个接口,这是直接原因,让安卓减少调这个接口次数,问题可以解决。但就算安卓连续调两次,也不应该出现这种问题,这说明后端代码还是出现了问题,接下来就算继续debug调试排查。 经过多次调试,发现第一次进来没问题,数据完整产生,而且正常回调回去,紧接着第二次进来,走同样的代码,数据库已经有数据,但如下图缺一直读不到数据,一直是空的状态,开始怀疑mybatis缓存问题。4、穿插一个知识,mybatis的一二级缓存https://tech.meituan.com/2018/01/19/mybatis-cache.html二级缓存介绍 在上文中提到的一级缓存中,其最大的共享范围就是一个SqlSession内部,如果多个SqlSession之间需要共享缓存,则需要使用到二级缓存。开启二级缓存后,会使用CachingExecutor装饰Executor,进入一级缓存的查询流程前,先在CachingExecutor进行二级缓存的查询,具体的工作流程如下所示。 二级缓存开启后,同一个namespace下的所有操作语句,都影响着同一个Cache,即二级缓存被多个SqlSession共享,是一个全局的变量。当开启缓存后,数据的查询执行的流程就是 二级缓存 -> 一级缓存 -> 数据库。总结MyBatis的二级缓存相对于一级缓存来说,实现了SqlSession之间缓存数据的共享,同时粒度更加的细,能够到namespace级别,通过Cache接口实现类不同的组合,对Cache的可控性也更强。MyBatis在多表查询时,极大可能会出现脏数据,有设计上的缺陷,安全使用二级缓存的条件比较苛刻。在分布式环境下,由于默认的MyBatis Cache实现都是基于本地的,分布式环境下必然会出现读取到脏数据,需要使用集中式缓存将MyBatis的Cache接口实现,有一定的开发成本,直接使用Redis、Memcached等分布式缓存可能成本更低,安全性也更高。与执行select不同的是,执行update,insert,delect操作后会清空一级缓存中的数据,而不是通过算法生成缓存的键值存入一级缓存,之所以有这种差别是因为 select的flushCache(清空缓存)默认为false,而update,insert,delect的flushCache(清空缓存)默认为true。5.百度到的结果,很明显是清空缓存flushCache = true,如下图6.使用百度的做法,进行调试,结果还是不尽人意,如下图还是重复数据。7、这使我们开始怀疑,mybatis这个调试是否有用,是否真的清除缓存,带着这个疑问,开始调试数据库,看是否两次都有执行数据库查询,还是只有执行一次,代码如下图:调试的结果是,已经执行了两次,缓存也清除,说明我们刚的做法没错,回头想一想,结合一二级缓存原理,增删改情况也会清除缓存,多次测试结果一样,问题还是没解决。总结,不是mybatis的问题,后面开始对配置文件下手,感觉有问题,如下图配置,进行了修改补充,多次调试执行的结果还是一样,没有用。百度到下图信息,看着好像很有道理,但感觉跟这个就没关系,所以就没去试,后面也证实这样做是对的:8.接下操作开始比较贴近解决问题的方法了 事物问题,大哥提出了两个数据库产生事物锁的方法,要解决读取不到数据,或脏读的情况,如下图,每次进入该方法都会到数据库修改count字段,每次都加一,意思是要么都成功,要么都失败,这样就相当于数据库产生的事物锁。多次调试,每次进入同样会加一,说明这个锁的方向还是错误。9.冲突问题10.了解下事物的隔离级别11.详细隔离级别和锁:https://www.cnblogs.com/tian666/p/7852646.html12.最终解决问题的办法是,调整springboot的事物隔离级别,改成不可重复读级别就可以完美解决问题。13.spring的7种事物传播行为各个传播行为是干什么详解https://www.cnblogs.com/ll409546297/p/11076258.html14.事物的特性

您的IP: